Kami menggunakan generator yang Robots.txt untuk membuat file robots.txt.

Menganalisis file robots.txt Anda

Kami menggunakan analisa Robots.txt untuk menganalisis file robots.txt Anda hari ini.

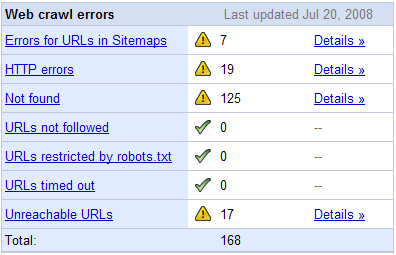

Google juga menawarkan di dalam alat serupa dari Google Webmaster Central , dan menunjukkan kesalahan merangkak Google untuk situs Anda.

Contoh Format Robots.txt

Memungkinkan pengindeksan segalanya

User-agent: *Disallow:

Larang pengindeksan segalanya

User-agent: *Disallow: /

Googlebot Disallow pengindeksan folder, kecuali untuk memungkinkan pengindeksan satu file dalam folder itu

User-agent: GooglebotDisallow: / folder1 /Allow: / folder1/myfile.html

Latar Belakang Informasi tentang File Robots.txt

- Robots.txt file menginformasikan spider mesin pencari bagaimana berinteraksi dengan pengindeksan konten Anda.

- Mesin pencari default dengan serakah. Mereka ingin informasi indeks kualitas yang jauh tinggi karena mereka bisa, dan mereka akan berasumsi bahwa mereka dapat merangkak segalanya kecuali Anda memberitahu mereka sebaliknya.

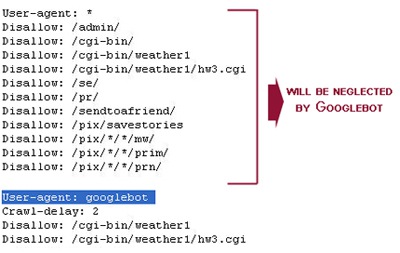

- Jika Anda menetapkan data untuk semua bot (*) dan data untuk bot tertentu (seperti Googlebot) maka perintah bot tertentu akan diikuti dengan mesin yang mengabaikan perintah bot global / standar .

- Jika Anda membuat perintah global yang Anda ingin berlaku untuk bot tertentu dan Anda memiliki aturan spesifik lainnya untuk itu bot maka Anda perlu untuk menempatkan perintah-perintah global dalam bagian untuk bot itu juga, seperti yang disorot dalam artikel ini oleh Ann Smarty .

- Jika Anda membuat perintah global yang Anda ingin berlaku untuk bot tertentu dan Anda memiliki aturan spesifik lainnya untuk itu bot maka Anda perlu untuk menempatkan perintah-perintah global dalam bagian untuk bot itu juga, seperti yang disorot dalam artikel ini oleh Ann Smarty .

- Bila Anda memblokir URL dari diindeks di Google melalui robots.txt mereka masih dapat menunjukkan halaman-halaman seperti daftar URL hanya dalam hasil pencarian mereka. Sebuah solusi yang lebih baik untuk benar-benar memblokir indeks dari suatu halaman tertentu adalah dengan menggunakan tag meta robot noindeks pada basis per halaman. Anda dapat memberitahu mereka untuk tidak mengindeks halaman, atau untuk tidak mengindeks halaman dan untuk tidak mengikuti link keluar dengan memasukkan salah satu dari bit-bit kode berikut di kepala dokumen HTML Anda bahwa Anda tidak ingin diindeks.

- Perlu diketahui bahwa jika Anda memblokir mesin pencari dalam robots.txt dan melalui meta tag maka mereka tidak mungkin bisa menjelajah halaman untuk melihat meta tag, sehingga URL masih dapat muncul dalam hasil pencarian hanya URL.

- Jika Anda tidak memiliki file robots.txt, log server Anda akan kembali 404 bot kesalahan setiap kali mencoba mengakses file robots.txt Anda. Anda dapat meng-upload file robots.txt teks kosong bernama di root situs Anda (misalnya: seobook.com / robots.txt ) jika Anda ingin berhenti mendapatkan 404 kesalahan, tetapi tidak ingin menawarkan perintah khusus untuk bot.

- Beberapa mesin pencari memungkinkan Anda untuk menentukan alamat dari XML Sitemap dalam file robots.txt Anda, tetapi jika situs Anda adalah terstruktur dengan baik dengan struktur link bersih Anda tidak perlu untuk membuat sitemap XML.

Keterlambatan Crawl

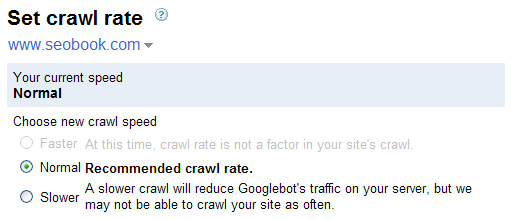

- Search engine memungkinkan Anda untuk mengatur prioritas merangkak.

- Google tidak mendukung perintah penundaan merangkak secara langsung, tapi Anda dapat menurunkan prioritas merangkak Anda di dalam Google Webmaster Central.

- Google memiliki volume tertinggi pangsa pasar pencarian di sebagian besar pasar, dan memiliki salah satu prioritas merangkak paling efisien, sehingga Anda tidak perlu mengubah prioritas perayapan Google.

- Anda dapat mengatur penundaan Yahoo! Slurp merangkak dalam file robots.txt Anda. Yahoo! menawarkan informasi latar belakang sini .

- Robots.txt merangkak kode keterlambatan mereka terlihat seperti User-agent: Slurp Crawl-delay: 5 mana 5 adalah dalam detik.

- Informasi Microsoft terletak di menu Bantuan Live sini , tapi agak sulit untuk menemukan.

- Robots.txt merangkak kode keterlambatan mereka terlihat seperti User-agent: msnbot Crawl-delay: 10 dimana 10 adalah dalam detik.

Pencocokan Wildcard Robots.txt

Google, Yahoo! Search, dan Microsoft memungkinkan penggunaan wildcard dalam file robots.txt.

(?) Untuk memblokir akses ke semua URL yang mencakup tanda tanya, Anda dapat menggunakan entri berikut:

User-agent: *Disallow: / *?

Anda dapat menggunakan karakter $ untuk menentukan pencocokan akhir URL. Misalnya, untuk memblokir URL yang berakhir dengan asp, Anda dapat menggunakan entri berikut.:

User-agent: GooglebotDisallow: / *. asp $

URL Tertentu Tips

Bagian dari membuat file robots.txt yang bersih dan efektif adalah memastikan bahwa struktur situs Anda dan nama file yang dibuat berdasarkan strategi suara. Apa adalah beberapa tips favorit saya?

- Hindari Tanggal di URL: Jika pada beberapa titik waktu Anda ingin menyaring arsip berdasarkan tanggal maka Anda tidak ingin tanggal di path file Anda dari halaman reguler Anda isi atau mudah untuk menyaring URL biasa. Ada banyak alasan lain untuk menghindari tanggal di URL juga.

- Akhir URL dengan garis miring terbalik: Jika Anda ingin memblokir nama file pendek dan tidak memiliki sebuah backslash di akhir jika kemudian Anda secara tidak sengaja bisa berakhir memblokir halaman penting lainnya.

- Pertimbangkan URL terkait jika Anda menggunakan wildcard Robots.txt: Saya sengaja biaya sendiri lebih dari $ 10.000 dalam labadengan satu kesalahan robots.txt!

- Dinamis Menulis ulang URL: Yahoo! Cari menawarkan penulisan ulang URL dinamis , tapi karena kebanyakan mesin pencari lain tidak menggunakannya, Anda mungkin lebih baik menulis ulang URL Anda dalam file htaccess. Anda bukan menciptakan tambahan ulang hanya untuk Yahoo! Search.

- Lebih URL tips dalam file penamaan bagian kami program pelatihan SEO .

Sumber Data

- wawancara 2007 dari Cutts Google Matt oleh Eric Enge .

- pengumuman dari elemen = rel kanonik .

- Vanessa Fox melaporkan 2009 konferensi Google I / O .

- Matt Cutts 2009 posting di rel PageRank = "nofollow" mengkonsumsi .

Lebih Robots.txt Sumber Daya

- Mengontrol Merangkak dan Pengindeksan - "Dokumen ini merupakan penggunaan saat ini dari web-crawler arahan kontrol robots.txt serta arahan pengindeksan seperti yang biasa digunakan di Google Petunjuk ini umumnya didukung oleh semua web crawler utama dan mesin pencari.."

- Robots Exclusion Protocol untuk Google & Microsoft Bing

- Jane dan robot - Vanessa Fox menawarkan tips tentang mengelola akses robot ke website Anda.

- robotstxt.org - situs resmi sekolah tua tentang robot web dan robots.txt

Memperoleh Keunggulan Kompetitif Hari ini

Ingin lebih besar wawasan SEO? Baca kami SEO blog untuk bersaing dengan pencari berita terbaru mesin, dan berlangganan ke kami pelatihan SEO program untuk mendapatkan pemotongan tepi kiat kita tidak berbagi dengan masyarakat umum. Program pelatihan kami juga menawarkan video eksklusif SEO .

Administrator

Administrator